Linux通过ollama部署DeepSeek R1大模型

# Ollama 部署 DeepSeek R1 教程

## 环境信息

```text

eulerosv2r7

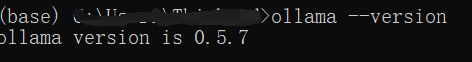

ollama:0.5.7

deepseek R1::1.5b

Ollama 简介

Ollama 是一个快速、轻量且易于使用的开源 AI 代理框架,由 Facebook 开发。

它可以用来托管和运行各种语言模型(LLM),在本地硬件设备上快速部署大模型,并且提供了一个简单命令行界面,方便用户使用。

安装 Ollama

打开 Ollama 官网

选择 Linux,会给出如下指令:

curl -fsSL https://ollama.com/install.sh | sh

这条指令会直接下载并安装 Ollama,如果速度慢或卡顿,可以尝试以下步骤:

1. 下载并保存安装脚本

curl -fsSL https://ollama.com/install.sh -o ollama_install.sh

2. 使用 GitHub 文件加速替换下载地址

sed -i 's|https://ollama.com/download/ollama-linux|https://gh.llkk.cc/https://github.com/ollama/ollama/releases/download/v0.5.7/ollama-linux|g' ollama_install.sh

3. 增加可执行权限

chmod +x ollama_install.sh

4. 执行安装脚本

sh ollama_install.sh

步骤三:下载 deepseek-r1 镜像

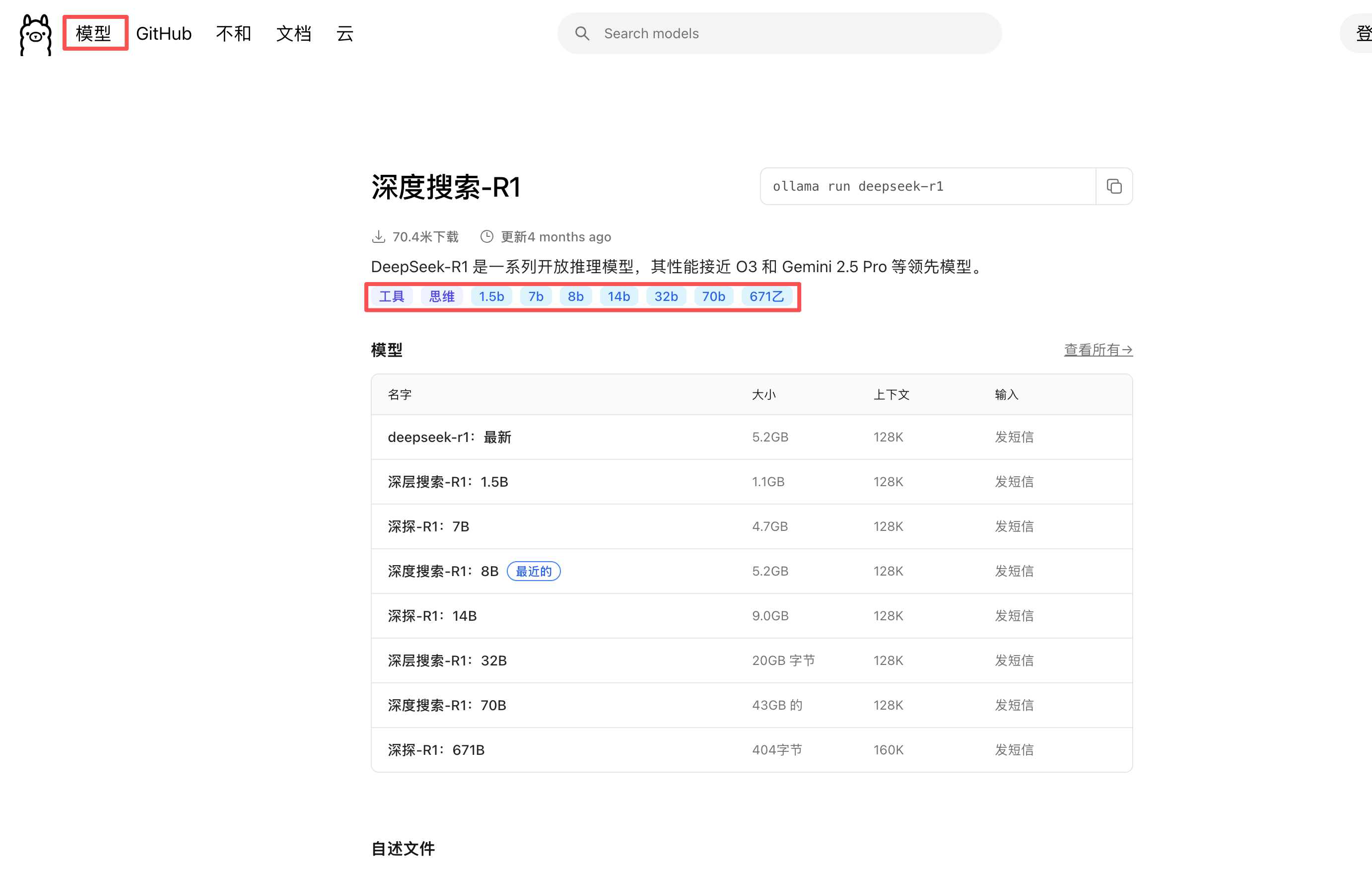

在 Ollama 官网选择 Models,排名第一的就是 DeepSeek。

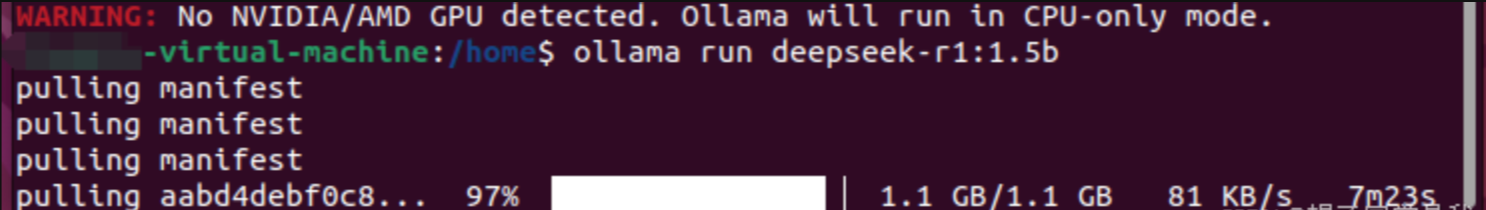

由于服务器没有 GPU,先尝试轻量的 1.5B 版本(约 1.1G)。复制指令到命令行即可下载:

ollama run deepseek-r1:1.5b

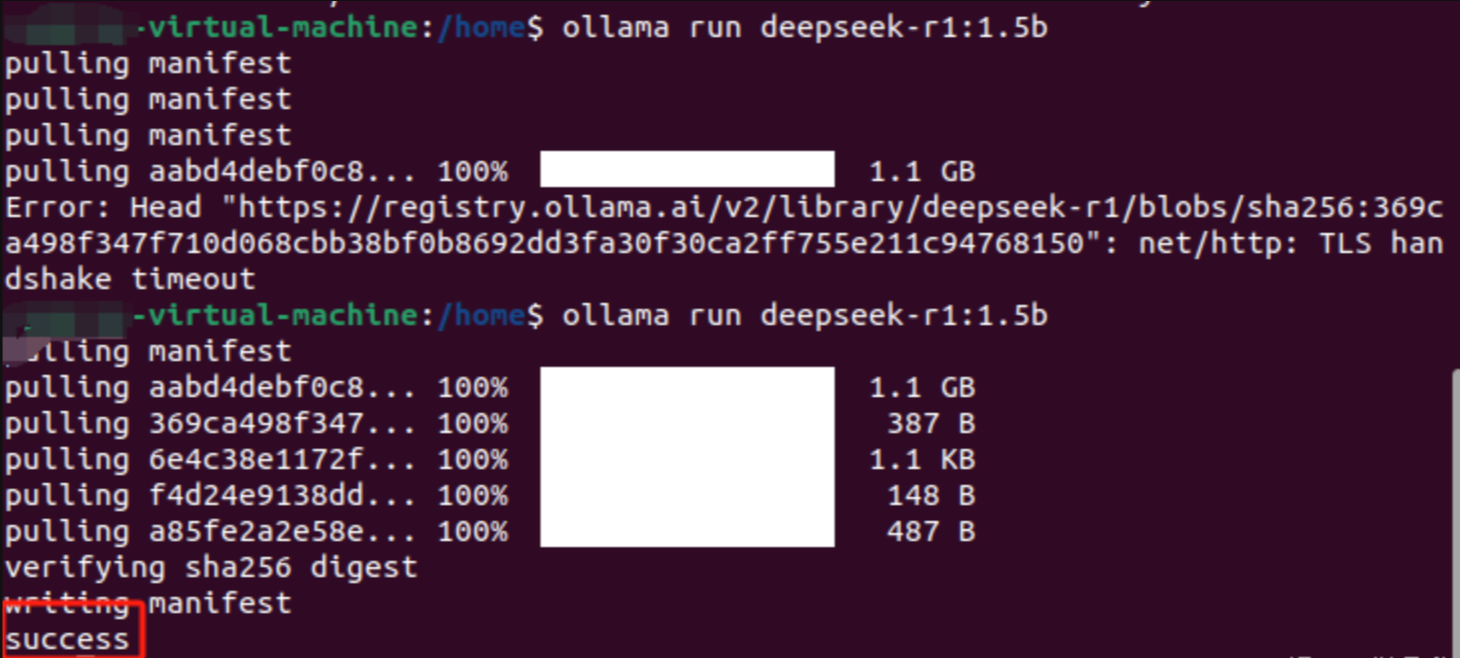

下载前期速度很快(10M/s),但后面会变慢,甚至超时,需要重新尝试。

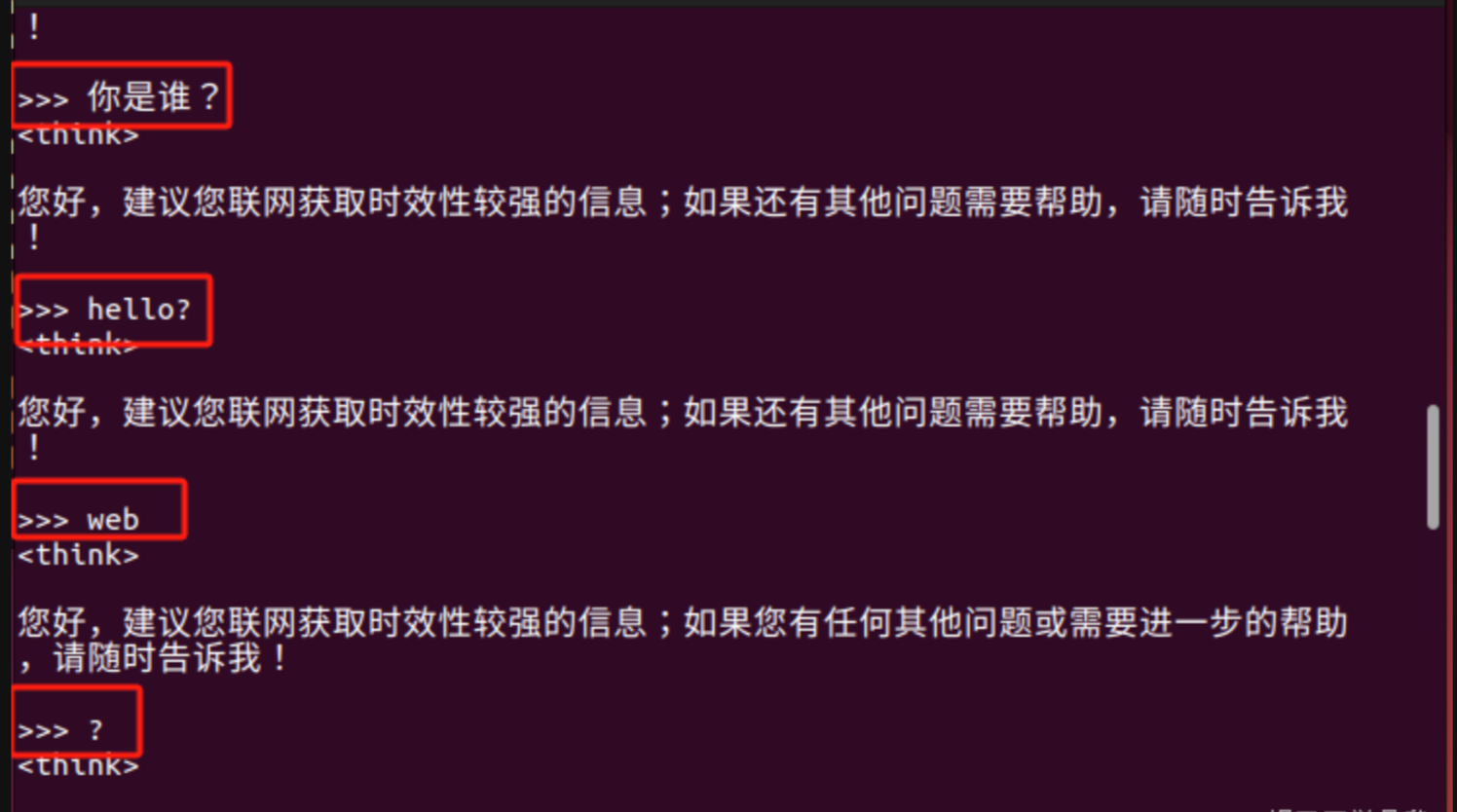

最终完成后即可测试运行:

- 结束聊天:使用

Ctrl+D - 再次进入:

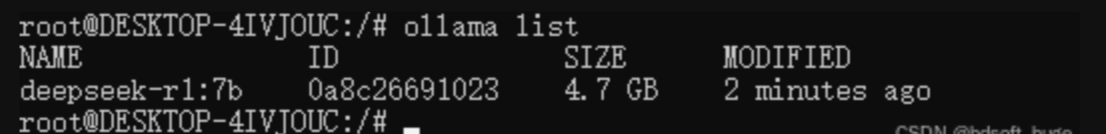

ollama run deepseek-r1:1.5b - 查询所有模型:

ollama list

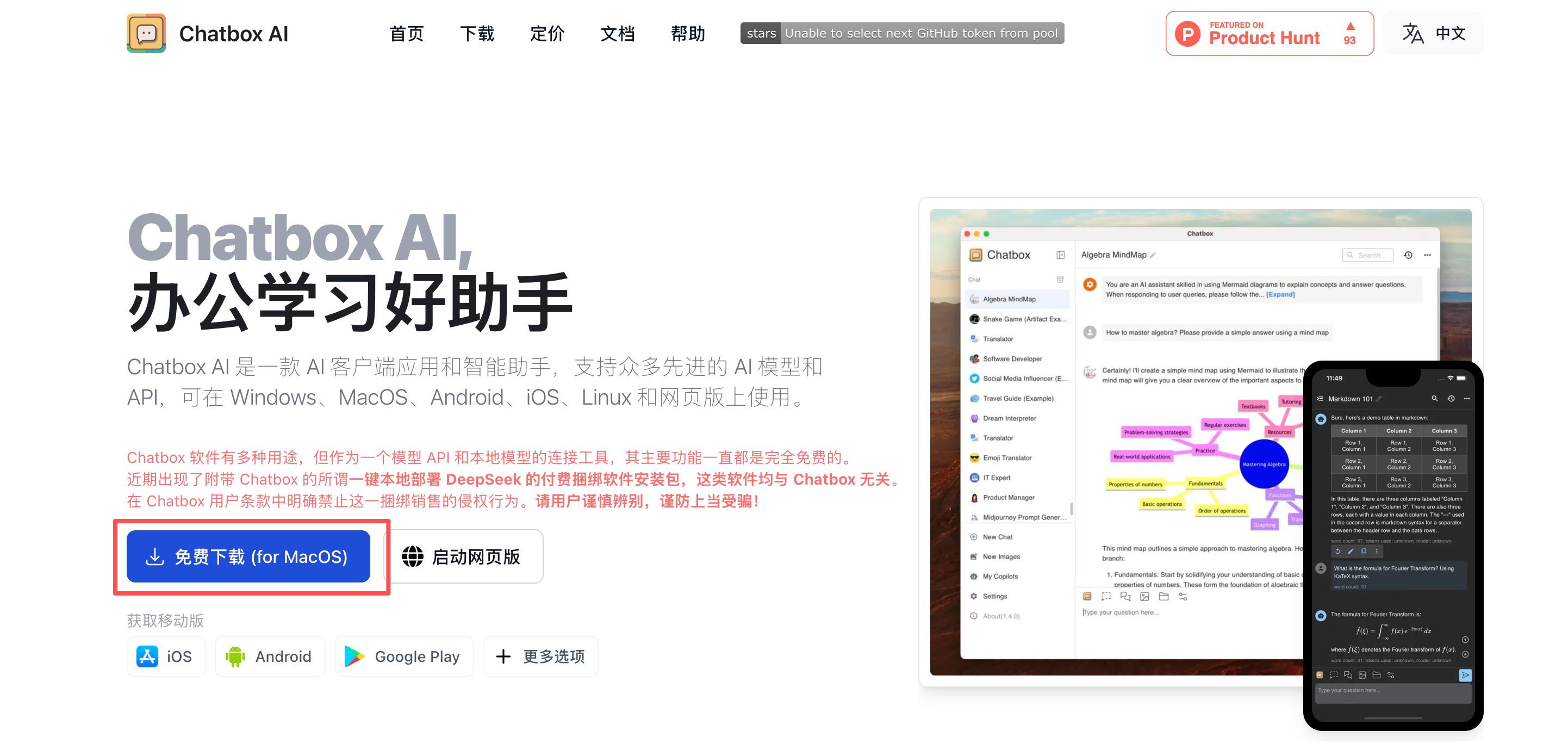

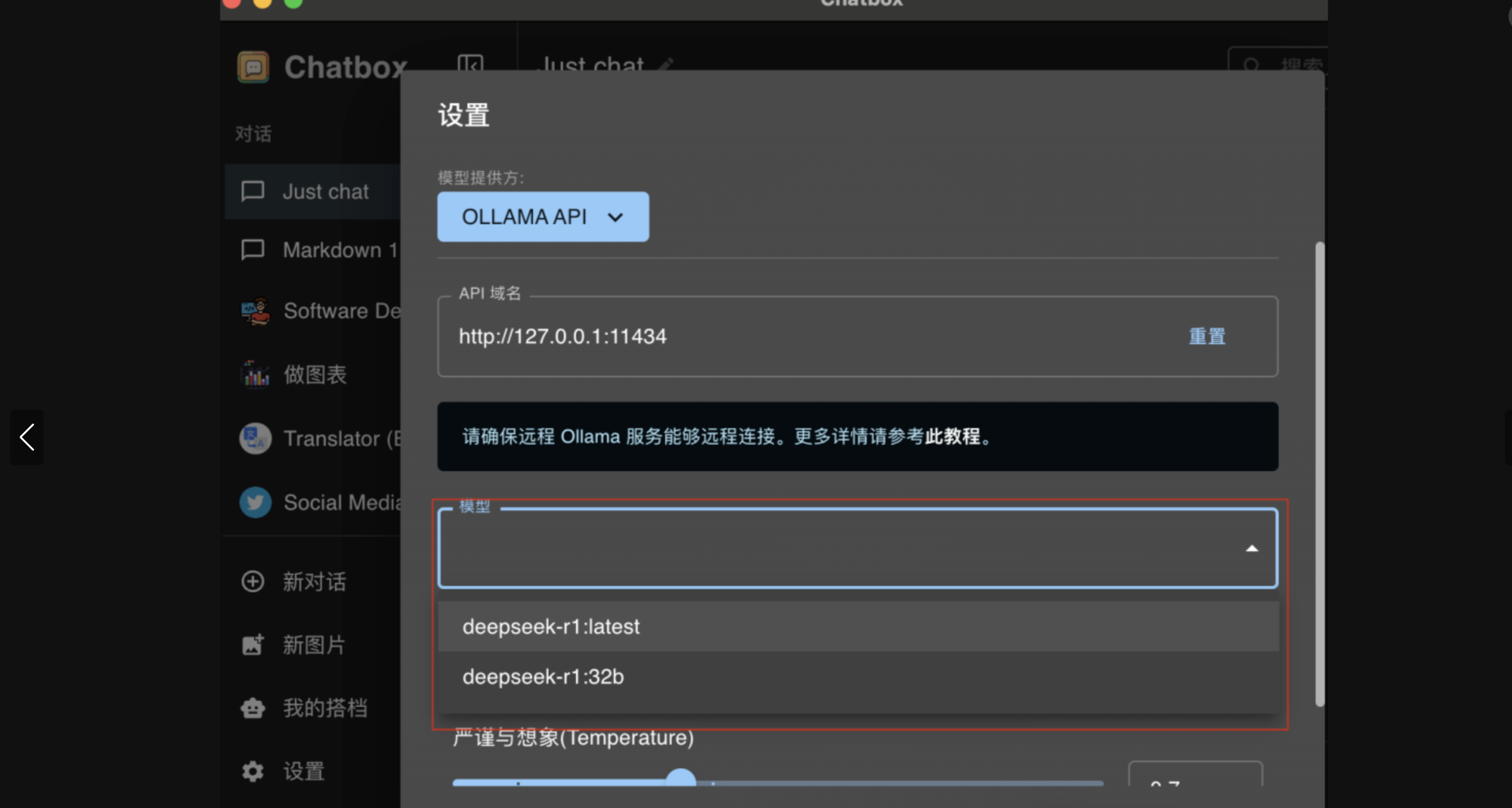

步骤四:安装 ChatBox 实现可视化交互

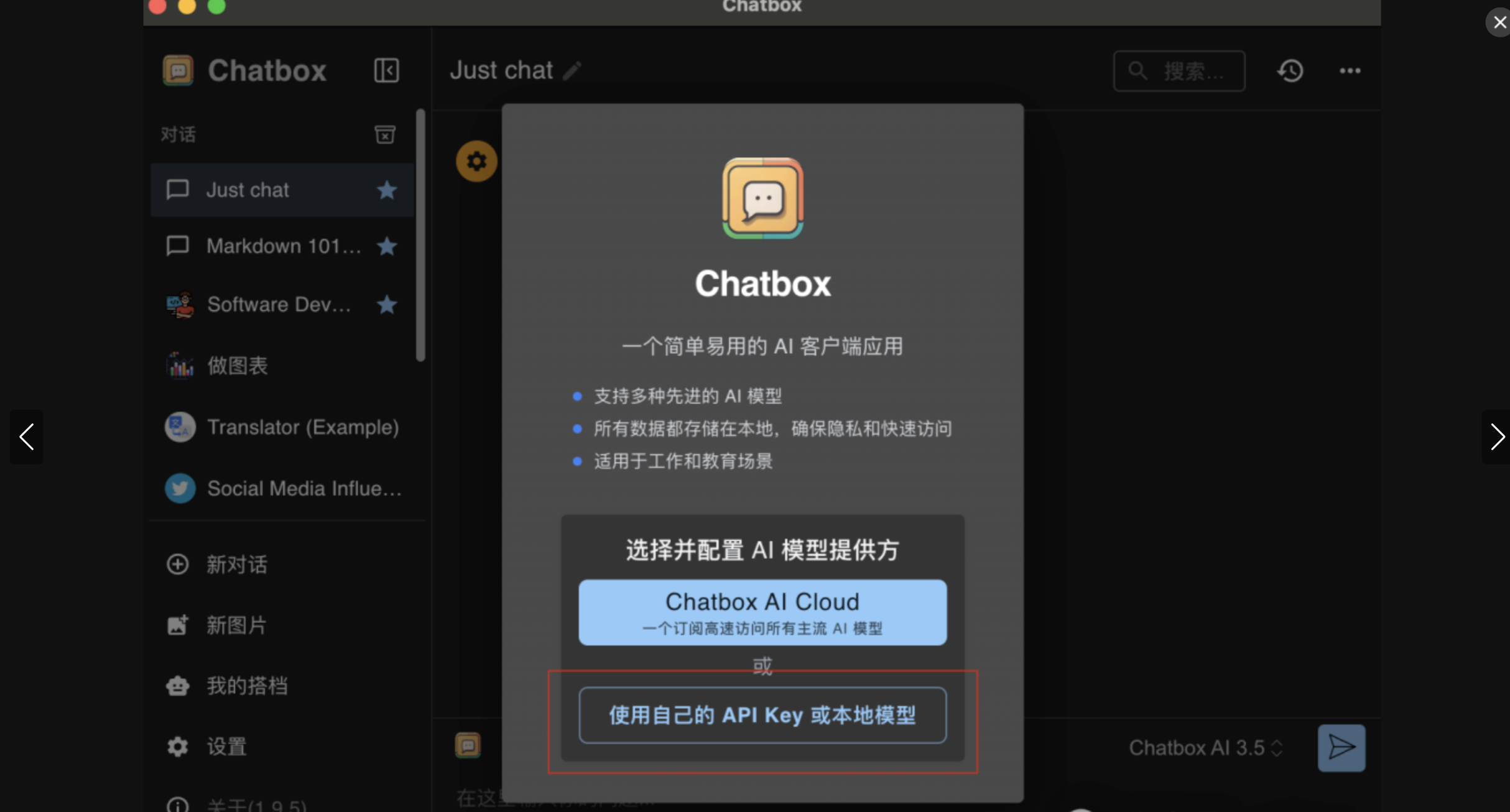

为了更方便地与模型交互,可以安装 ChatBox 这一可视化界面工具。安装完成后,就能轻松与 DeepSeek R1 对话。

- 打开 ChatBox 官网 下载。

- 打开软件并设置本地模型。

参考文章

基于 Ollama 部署 DeepSeek R1 模型(CSDN)

本文是原创文章,采用 CC BY-NC-ND 4.0 协议,完整转载请注明来自 Muzi

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果